内存计算可以解决AI内存平衡的音量,速度和处理行为

11月03日,2020年经过杰克赫兹设计用于AI / ML设备的内存架构可能觉得可以感到不可通过妥协,存储体积,速度和处理。新的内存计算加速器可以是有用的解决方案。

随着AI/ML的出现,计算系统面临着前所未有的内存挑战。AI/ML应用程序和设备的独特之处在于,它们需要以尽可能快的速度和尽可能低的功耗并行访问大量数据。

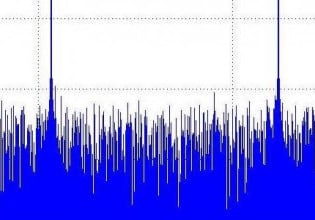

记忆墙具有越来越有限的计算系统。图片使用的礼貌华盛顿大学

在本文中,我们将探索beplay体育下载不了AI/ML工作负载对内存的需求以及工程师们如何着手解决这些问题。

量的要求

AI才会出现的原因之一是它需要大量数据。作为这件证明,特斯拉积累了超过13亿英里的驾驶数据建立其AI基础设施的同时微软需要五年的持续语音数据来教导电脑谈话。

特斯拉的自动驾驶功能“学习”示意图使用的图像礼貌在EVS里面

显然,要管理这些海量数据,内存系统将需要增加容量和可伸缩性。工程师们曾考虑过简单地增加更大的内存系统,但这是以性能下降为代价的。

设计师还调查了更有效地存储内存的方法数据湖泊,它们是集中式存储库,允许存储任意规模的结构化或非结构化数据。

要求速度

随着AI/ML应用程序进入需要实时决策的关键任务应用程序,速度至关重要。想想一个自主车:如果它不能在一秒钟的分数中做出决定,这可能是司机,行人或道路上的其他人的生命或死亡问题。

对话框半导体位置是最实惠的系统基于“没有任何内部NVM的单个芯片SOC”。使用的图像礼貌对话框半导体

不幸的是,这种要求速度与更大的内存存储直接冲突。von Neumann架构的众所周知的记忆墙基本上保持了较大的内存意味着较慢的内存。出于这个原因,工程师正在考虑将Von Neumann架构的模具与内存计算作为新概念。

对电力效率的要求

与速度需求直接相反的是对功率效率的需求。第一代具备人工智能功能的设备,比如亚马逊的Alexa,由于电力消耗巨大,需要将设备插入电源插座。

现在,下一代是针对的独立,电池供电的设备,使电力效率最高。

数据运动能量的影响。使用的图像礼貌冯石等。

从传统的观点来看,片上动态功耗引入了功率和速度之间的冲突;系统频率越高,功耗越高。然而,比这更重要的是丹尼德缩放已导致数据移动能量是芯片上功耗最大的贡献者。

这一现实与人工智能应用的大容量需求相冲突,需要移动大量数据。再一次,内存计算的概念似乎是这个问题的解决方案。

解开人工智能的记忆解决方案

一些公司和研究团体,如IMEC和全球铸造厂通过构建具有内存内部网络处理的AI芯片来侧踩到von neumann瓶颈。

其他的,如Untether AI,希望通过利用内存计算来解决AI/ML在速度、存储和功耗方面的冲突,如在新的Tsunaimi加速器中所见。

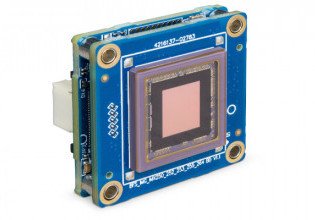

新的Tsunaimi加速器。使用的图像礼貌把人工智能

这款新加速器提供了一些令人印象深刻的规格:每秒最多两种铺升(POPS),标准PCI-Express卡片外形和8个顶部/次的电源效率。这些结果是不受限制的索赔,比最近的竞争对手快三到四倍(取决于应用程序)。

在其内存计算架构的核心,是一个存储体,包括385 kBs的SRAM,具有2D 512处理元件。每台芯片511个银行,每个设备提供200 MB的内存,并在其“运动”模式下最多可操作502顶部。为了最大功率效率,该设备提供8个顶部/型的“ECO”模式。

内存计算的未来

随着人工智能的存在,许多工程师的一个核心问题将是如何克服独特的、相互冲突的内存需求。随着内存计算成为一种潜在的解决方案,Untether AI和Imec等公司似乎在朝着正确的方向思考。

你对AI/ML应用的内存架构有经验吗?你面临怎样的设计挑战?请在下面的评论中分享你的想法。